Nvidia introduceert DGX Vera Rubin: AI-server met eigen CPU

Nvidia heeft tijdens CES 2026 de nieuwe generatie AI-servers gepresenteerd onder de naam DGX Vera Rubin. Deze infrastructuuroplossing combineert een volledig zelf ontworpen ARM-gebaseerde CPU met een nieuwe generatie GPU’s. De Vera Rubin-architectuur is ontwikkeld om AI-werkbelasting efficiënter te verwerken en biedt datacenters meer rekenkracht per watt en rack dan eerdere systemen.

Lees verder na de advertentie

Nieuwe architectuur met eigen CPU en GPU

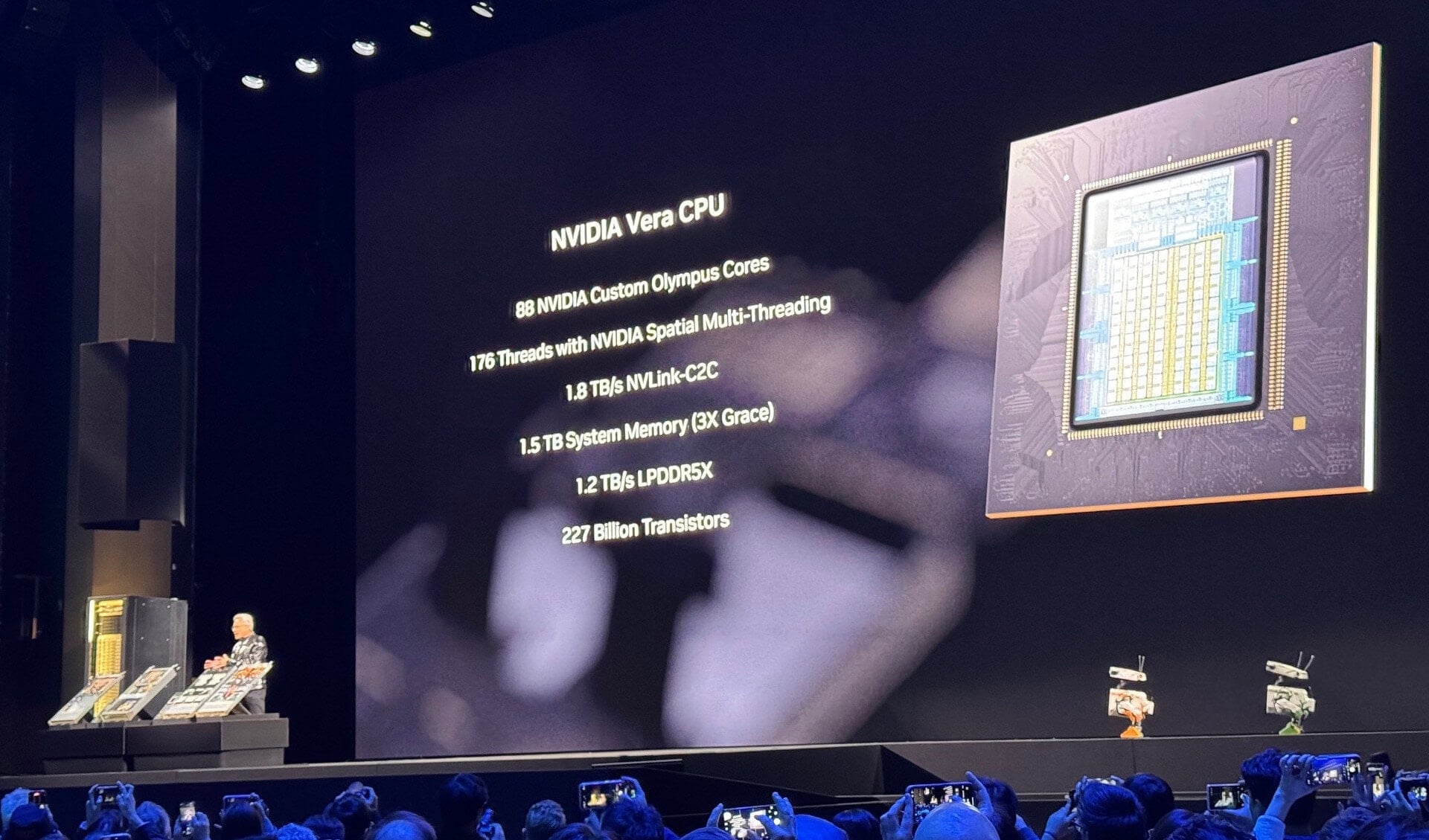

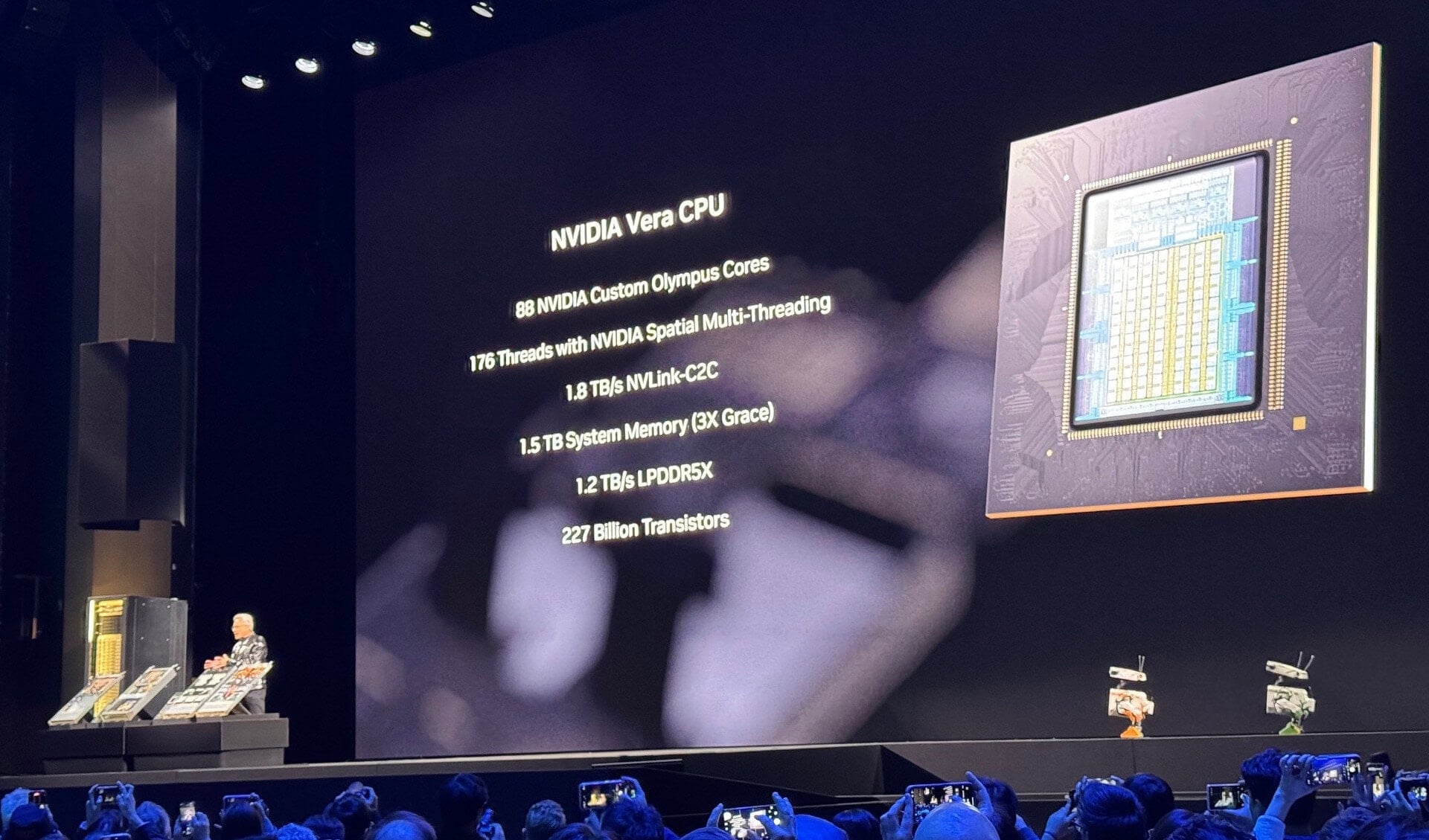

Centraal in de nieuwe generatie AI-infrastructuur staan twee componenten: de Vera CPU en de Rubin GPU. De CPU bevat 88 ARM-compatibele kernen met 176 threads en is volledig door Nvidia ontworpen. In tegenstelling tot eerdere systemen maakt Nvidia geen gebruik van standaard ARM Neoverse-kernen, maar kiest het voor een aangepaste architectuur gericht op maximale doorvoer voor AI-toepassingen.

De Rubin GPU is de opvolger van de Blackwell-serie en wordt volgens Nvidia tot vijf keer sneller in AI-berekeningen gemeten in FP4-prestaties. Deze GPU’s zijn gebouwd voor grootschalige generatieve AI-modellen met een focus op hoge geheugenbandbreedte en geoptimaliseerde rekeneenheden.

Integratie op rack-schaal met NVLink 6

De DGX Vera Rubin-architectuur draait om het samenbrengen van verschillende subsystemen tot één geïntegreerde AI-computer. In een volledige NVL72-configuratie worden 72 Rubin GPU’s gekoppeld via NVLink 6, waarmee ze als één logische eenheid functioneren. Dit moet de latentie verlagen en de schaalbaarheid van modellen verder vergroten.

Daarnaast bevat het systeem geavanceerde netwerkcomponenten zoals ConnectX-9 NICs, BlueField 4 DPU’s en Spectrum-switches die via optische verbindingen voor snelle gegevensoverdracht zorgen. Nvidia richt zich hiermee op AI-toepassingen die hoge eisen stellen aan bandbreedte, zoals LLM-training en real-time inferentie.

Verbeterde efficiëntie ten opzichte van Blackwell

Volgens Nvidia biedt de Vera Rubin-architectuur dezelfde rekenkracht met 72 GPU’s als de huidige DGX GB200-systemen met 144 GPU’s. De winst zit in een slimmere combinatie van CPU, GPU, geheugenarchitectuur en communicatielagen. De operationele kosten per gegenereerd token zouden tot 25 procent lager uitvallen dan bij de Blackwell-generatie, wat de aantrekkingskracht vergroot voor datacenters met focus op kosten- en energie-efficiëntie.

Onderhoudsvriendelijk en modulair

Opvallend aan het ontwerp is de modulaire opbouw zonder interne kabels, wat onderhoud en vervanging van onderdelen tijdens bedrijf vergemakkelijkt. Hierdoor wordt de beschikbaarheid in bedrijfskritische omgevingen vergroot, iets wat voor grote AI-clusters essentieel is.

De rackconfiguratie is schaalbaar en kan worden aangepast aan de gewenste capaciteit, zonder dat de architectuur of software stack aangepast hoeft te worden.

Vera Rubin: Introductie en beschikbaarheid

De eerste systemen worden in de tweede helft van 2026 verwacht bij datacenterpartners zoals CoreWeave, Microsoft en Oracle. Nvidia wil met deze stap verder uitgroeien van chipontwerper tot leverancier van complete AI-computingplatforms. De DGX Vera Rubin past in die strategie door CPU, GPU, netwerk en opslag volledig te integreren in één systeem.

Met deze nieuwe generatie zet Nvidia een duidelijke stap naar geïntegreerde en efficiëntere AI-infrastructuur. Voor organisaties die werken aan grootschalige AI-modellen belooft Vera Rubin niet alleen meer rekenkracht, maar vooral een betere verhouding tussen prestaties, energieverbruik en kosten.

Praat mee